Esquema ràpid

Aquesta publicació demostrarà:

Com implementar la lògica ReAct amb la botiga de documents a LangChain

- Instal·lació de Frameworks

- Proporcionar la clau de l'API OpenAI

- Importació de biblioteques

- Utilitzant l'Explorador de Viquipèdia

- Prova del model

Com implementar la lògica ReAct amb la botiga de documents a LangChain?

Els models d'idioma s'entrenen en un gran conjunt de dades escrites en idiomes naturals com l'anglès, etc. Les dades es gestionen i s'emmagatzemen als magatzems de documents i l'usuari simplement pot carregar les dades de la botiga i entrenar el model. L'entrenament del model pot prendre diverses iteracions, ja que cada iteració fa que el model sigui més eficaç i millorat.

Per conèixer el procés d'implementació de la lògica ReAct per treballar amb el magatzem de documents a LangChain, només cal que seguiu aquesta senzilla guia:

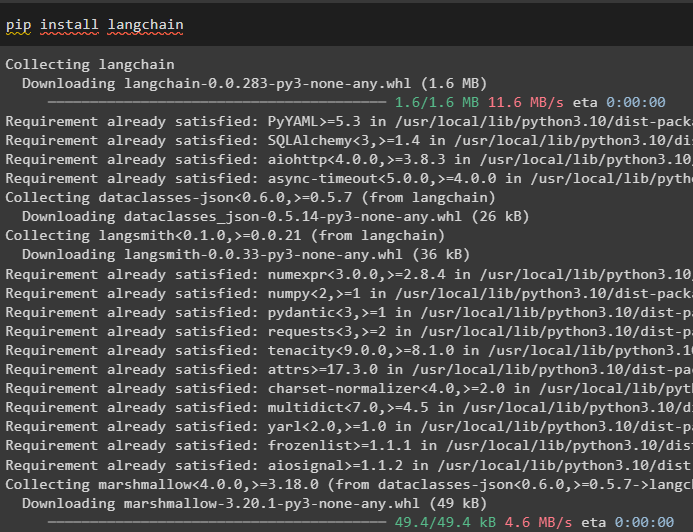

Pas 1: instal·lació de marcs

Primer, comenceu amb el procés d'implementació de la lògica ReAct per treballar amb el magatzem de documents mitjançant la instal·lació del marc LangChain. La instal·lació del marc de LangChain obtindrà totes les dependències necessàries per obtenir o importar les biblioteques per completar el procés:

pip install langchain

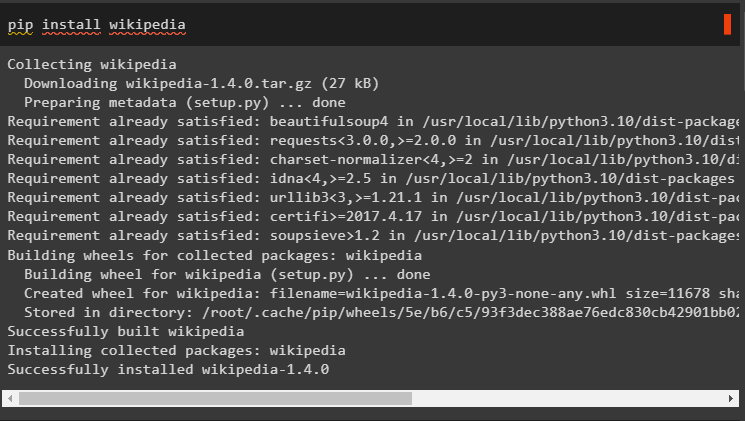

Instal·leu les dependències de la Viquipèdia per a aquesta guia, ja que es pot utilitzar per fer que els magatzems de documents funcionin amb la lògica ReAct:

pip install wikipedia

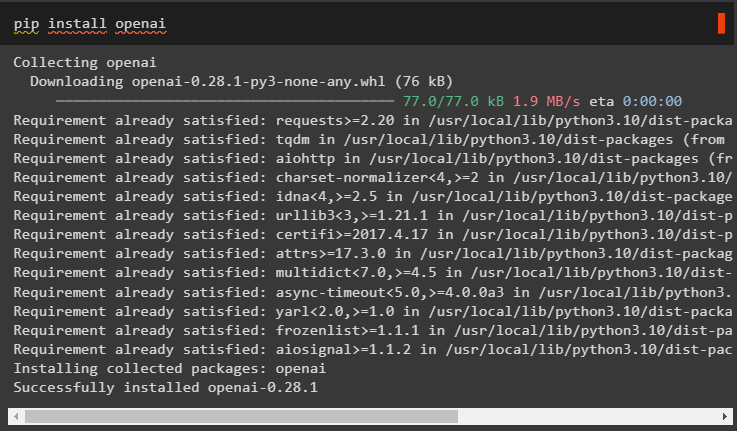

Instal·leu els mòduls OpenAI mitjançant l'ordre pip per obtenir les seves biblioteques i crear models de llenguatge grans o LLM:

pip install openai

Pas 2: proporcionar la clau de l'API OpenAI

Després d'instal·lar tots els mòduls necessaris, simplement configurar l'entorn utilitzant la clau API del compte OpenAI utilitzant el codi següent:

importar vostèimportar getpass

vostè . aproximadament [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'Clau de l'API OpenAI:' )

Pas 3: importació de biblioteques

Un cop configurat l'entorn, importeu les biblioteques del LangChain necessàries per configurar la lògica ReAct per treballar amb els magatzems de documents. Ús d'agents de LangChain per obtenir el DocstoreExplaorer i agents amb els seus tipus per configurar el model d'idioma:

des de langchain. llms importar OpenAIdes de langchain. docstore importar Viquipèdia

des de langchain. agents importar initialize_agent , Eina

des de langchain. agents importar Tipus d'agent

des de langchain. agents . reaccionar . base importar DocstoreExplorer

Pas 4: Ús de l'Explorador de Viquipèdia

Configura el ' docstore ” amb el mètode DocstoreExplorer() i crida al mètode Wikipedia() al seu argument. Creeu el model de llenguatge gran utilitzant el mètode OpenAI amb el ' text-davinci-002 ” model després de configurar les eines per a l'agent:

docstore = DocstoreExplorer ( Viquipèdia ( ) )eines = [

Eina (

nom = 'Cerca' ,

func = docstore. cerca ,

descripció = 'S'utilitza per fer consultes/sol·licituds amb la cerca' ,

) ,

Eina (

nom = 'Cercar' ,

func = docstore. Cercar ,

descripció = 'S'utilitza per fer consultes/sol·licituds amb la cerca' ,

) ,

]

llm = OpenAI ( temperatura = 0 , nom_model = 'text-davinci-002' )

#definint la variable configurant el model amb l'agent

reaccionar = initialize_agent ( eines , llm , agent = Tipus d'agent. REACT_DOCSTORE , verbosa = És cert )

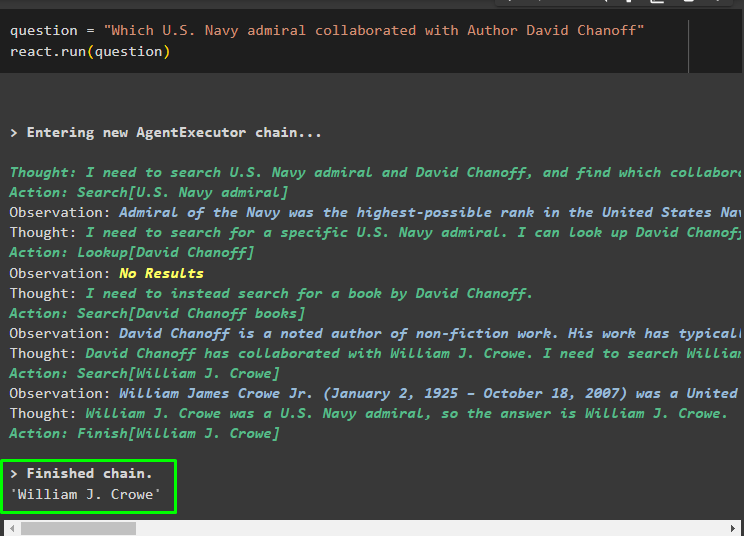

Pas 5: prova del model

Un cop construït i configurat el model, configureu la cadena de pregunta i executeu el mètode amb la variable de pregunta al seu argument:

pregunta = 'Quin almirall de la Marina dels Estats Units va col·laborar amb l'autor David Chanoff'reaccionar. correr ( pregunta )

Una vegada que s'executa la variable de pregunta, el model ha entès la pregunta sense cap plantilla ni formació externa d'indicadors. El model s'està entrenant automàticament utilitzant el model penjat al pas anterior i generant text en conseqüència. La lògica de ReAct està treballant amb els magatzems de documents per extreure informació basada en la pregunta:

Feu una altra pregunta a partir de les dades proporcionades al model des dels magatzems de documents i el model extreu la resposta de la botiga:

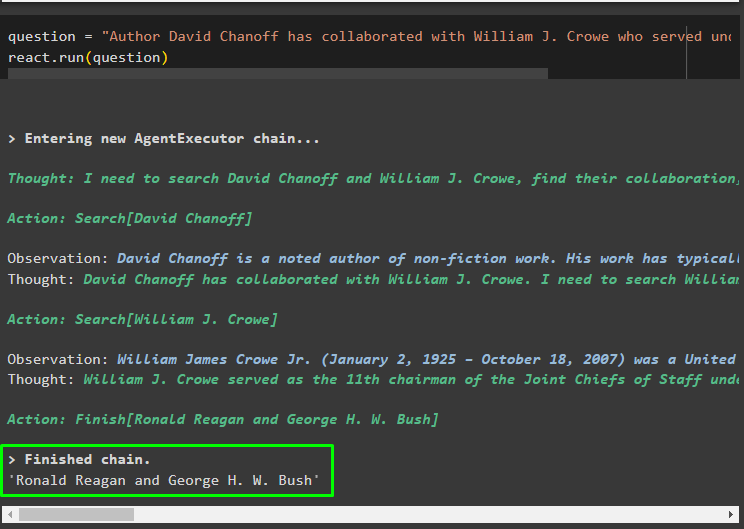

pregunta = 'L'autor David Chanoff ha col·laborat amb William J Crowe, que va exercir sota quin president?'reaccionar. correr ( pregunta )

Es tracta d'implementar la lògica ReAct per treballar amb el magatzem de documents a LangChain.

Conclusió

Per implementar la lògica ReAct per treballar amb el magatzem de documents a LangChain, instal·leu els mòduls o marcs per construir el model de llenguatge. Després d'això, configureu l'entorn per a OpenAI per configurar el LLM i carregar el model des del magatzem de documents per implementar la lògica ReAct. En aquesta guia s'ha desenvolupat la implementació de la lògica ReAct per treballar amb el magatzem de documents.