Aquesta guia il·lustrarà el procés d'ús de la memòria d'entitats a LangChain.

Com utilitzar la memòria d'entitats a LangChain?

L'entitat s'utilitza per mantenir els fets clau emmagatzemats a la memòria per extreure'ls quan l'ésser humà ho demani mitjançant les consultes/indicacions. Per conèixer el procés d'utilitzar la memòria d'entitats a LangChain, només cal que visiteu la guia següent:

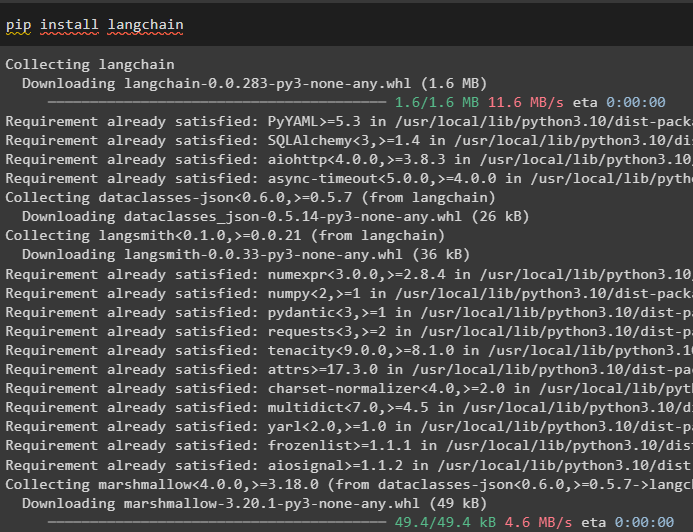

Pas 1: instal·leu els mòduls

Primer, instal·leu el mòdul LangChain mitjançant l'ordre pip per obtenir les seves dependències:

pip install langchain

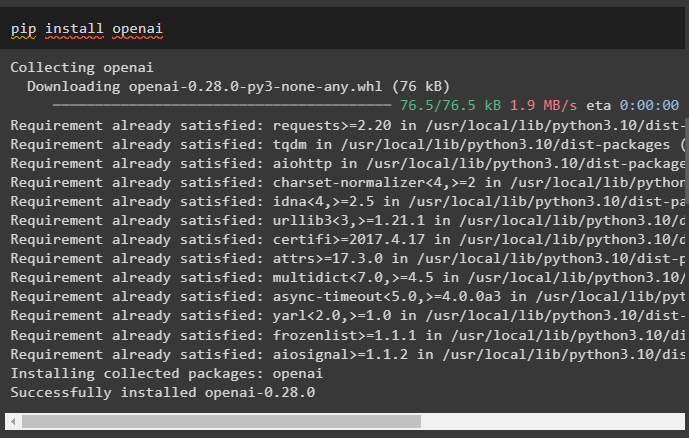

Després d'això, instal·leu el mòdul OpenAI per obtenir les seves biblioteques per crear LLM i models de xat:

pip install openai

Configura l'entorn OpenAI utilitzant la clau API que es pot extreure del compte OpenAI:

importar vostè

importar getpass

vostè . aproximadament [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'Clau de l'API OpenAI:' )

Pas 2: Ús de la memòria d'entitats

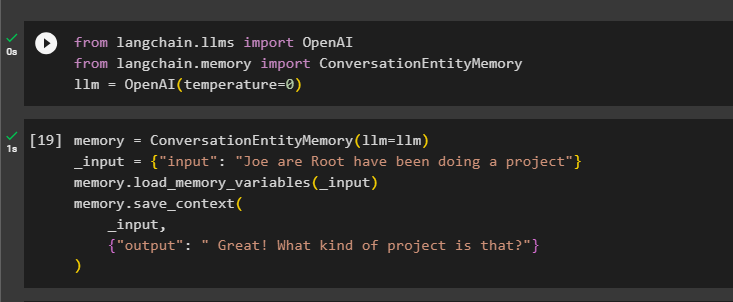

Per utilitzar la memòria d'entitats, importeu les biblioteques necessàries per crear el LLM mitjançant el mètode OpenAI():

des de langchain. llms importar OpenAIdes de langchain. memòria importar ConversationEntityMemory

llm = OpenAI ( temperatura = 0 )

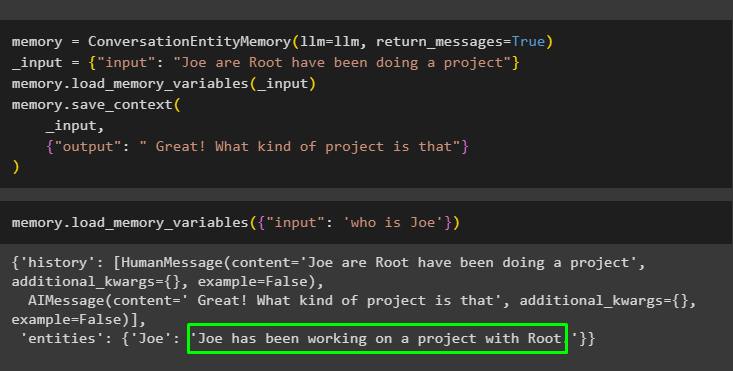

Després d'això, defineix el memòria variable utilitzant el mètode ConversationEntityMemory() per entrenar el model mitjançant les variables d'entrada i sortida:

memòria = ConversationEntityMemory ( llm = llm )_entrada = { 'entrada' : 'Joe are Root ha estat fent un projecte' }

memòria. load_memory_variables ( _entrada )

memòria. desa_context (

_entrada ,

{ 'sortida' : 'Genial! Quin tipus de projecte és aquest?' }

)

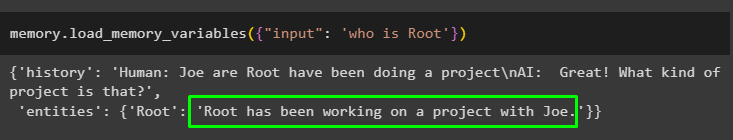

Ara, proveu la memòria utilitzant la consulta/indicació del fitxer entrada variable cridant al mètode load_memory_variables():

memòria. load_memory_variables ( { 'entrada' : 'qui és Root' } )

Ara, doneu més informació perquè el model pugui afegir algunes entitats més a la memòria:

memòria = ConversationEntityMemory ( llm = llm , missatges_retorn = És cert )_entrada = { 'entrada' : 'Joe are Root ha estat fent un projecte' }

memòria. load_memory_variables ( _entrada )

memòria. desa_context (

_entrada ,

{ 'sortida' : 'Genial! Quin tipus de projecte és aquest' }

)

Executeu el codi següent per obtenir la sortida utilitzant les entitats emmagatzemades a la memòria. És possible a través del entrada que conté la sol·licitud:

memòria. load_memory_variables ( { 'entrada' : 'qui és Joe' } )

Pas 3: Ús de la memòria d'entitats en una cadena

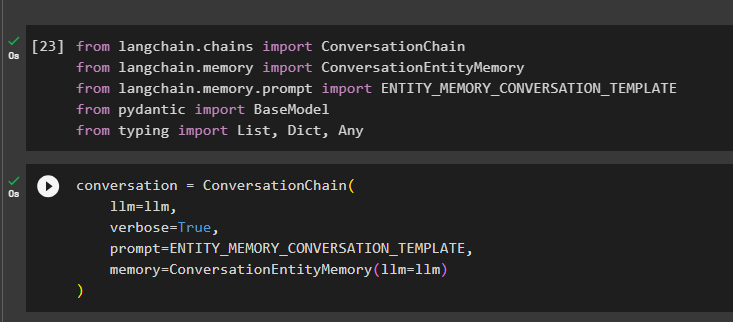

Per utilitzar la memòria d'entitats després de construir una cadena, només cal que importeu les biblioteques necessàries mitjançant el bloc de codi següent:

des de langchain. cadenes importar Cadena de conversades de langchain. memòria importar ConversationEntityMemory

des de langchain. memòria . prompte importar ENTITY_MEMORY_CONVERSATION_TEMPLATE

des de pidant importar Model base

des de escrivint importar Llista , Dict , Cap

Creeu el model de conversa utilitzant el mètode ConversationChain() utilitzant els arguments com llm:

conversa = Cadena de conversa (llm = llm ,

verbosa = És cert ,

prompte = ENTITY_MEMORY_CONVERSATION_TEMPLATE ,

memòria = ConversationEntityMemory ( llm = llm )

)

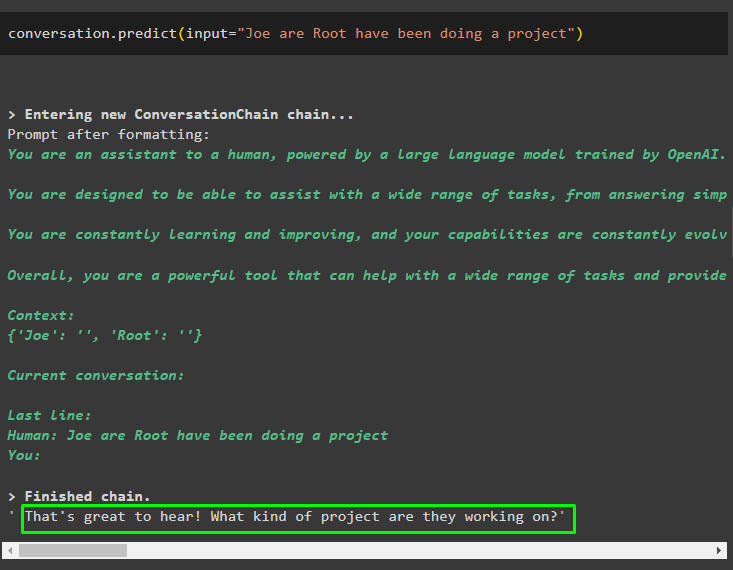

Truqueu al mètode conversation.predict() amb l'entrada inicialitzada amb l'indicador o la consulta:

conversa. predir ( entrada = 'Joe are Root ha estat fent un projecte' )

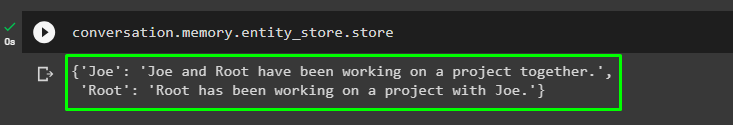

Ara, obteniu la sortida separada per a cada entitat que descriu la informació sobre aquesta:

conversa. memòria . entitat_botiga . botiga

Utilitzeu la sortida del model per donar l'entrada perquè el model pugui emmagatzemar més informació sobre aquestes entitats:

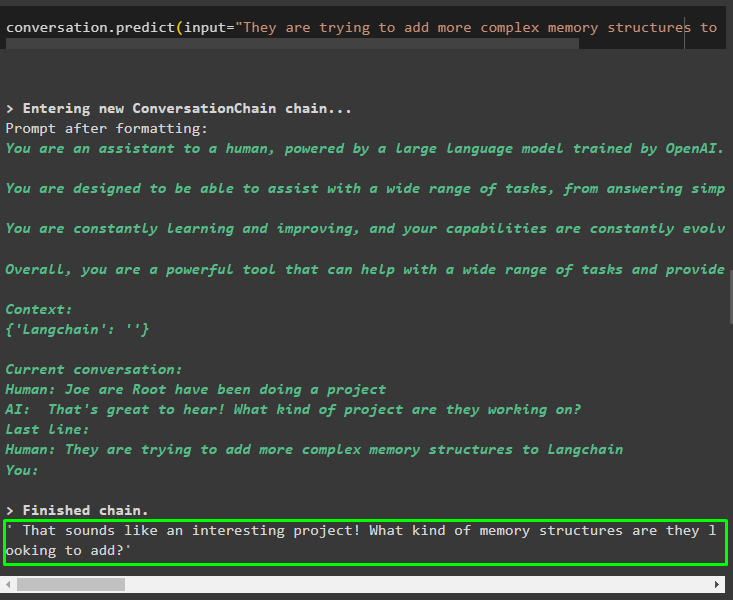

conversa. predir ( entrada = 'Estan intentant afegir estructures de memòria més complexes a Langchain' )

Després de donar la informació que s'emmagatzema a la memòria, només cal fer la pregunta per extreure la informació específica sobre les entitats:

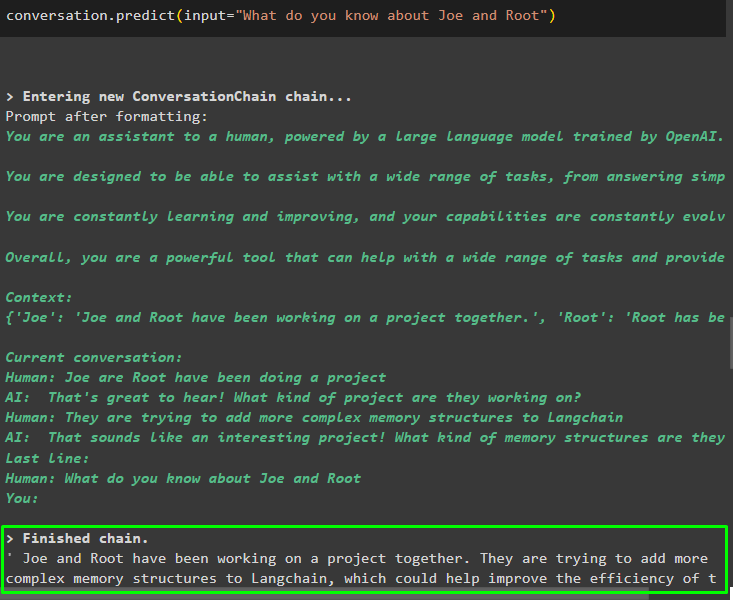

conversa. predir ( entrada = 'Què en saps sobre Joe i Root' )

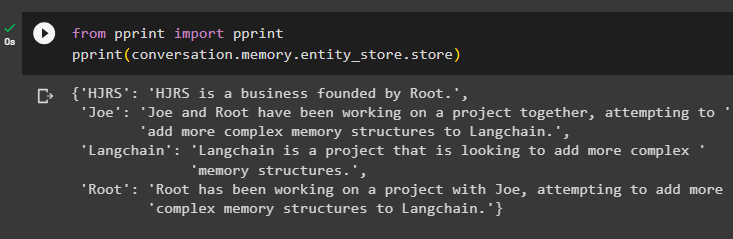

Pas 4: prova del magatzem de memòria

L'usuari pot inspeccionar directament els magatzems de memòria per obtenir la informació emmagatzemada en ells mitjançant el següent codi:

des de imprimir importar imprimirimprimir ( conversa. memòria . entitat_botiga . botiga )

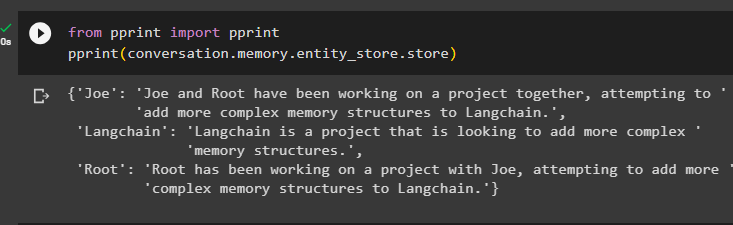

Proporcioneu més informació per emmagatzemar-la a la memòria, ja que més informació ofereix resultats més precisos:

conversa. predir ( entrada = 'Root ha fundat un negoci anomenat HJRS' )

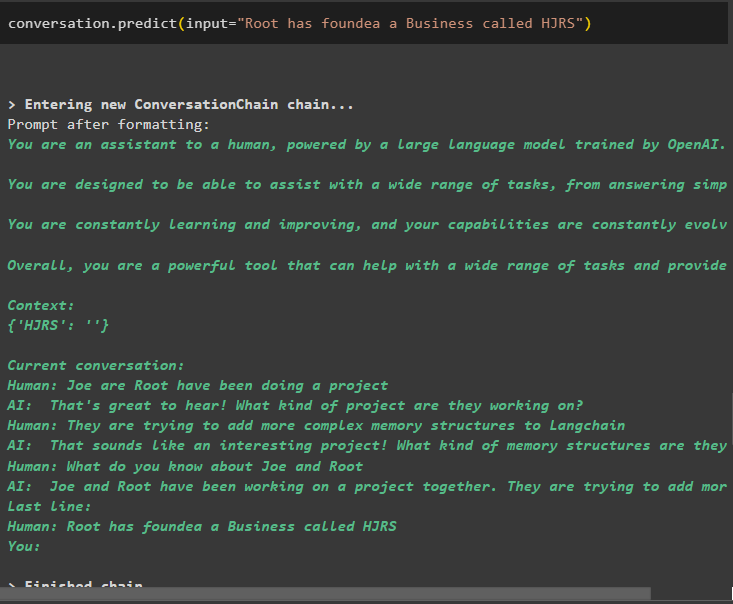

Extreu informació del magatzem de memòria després d'afegir més informació sobre les entitats:

des de imprimir importar imprimirimprimir ( conversa. memòria . entitat_botiga . botiga )

La memòria té informació sobre diverses entitats com HJRS, Joe, LangChain i Root:

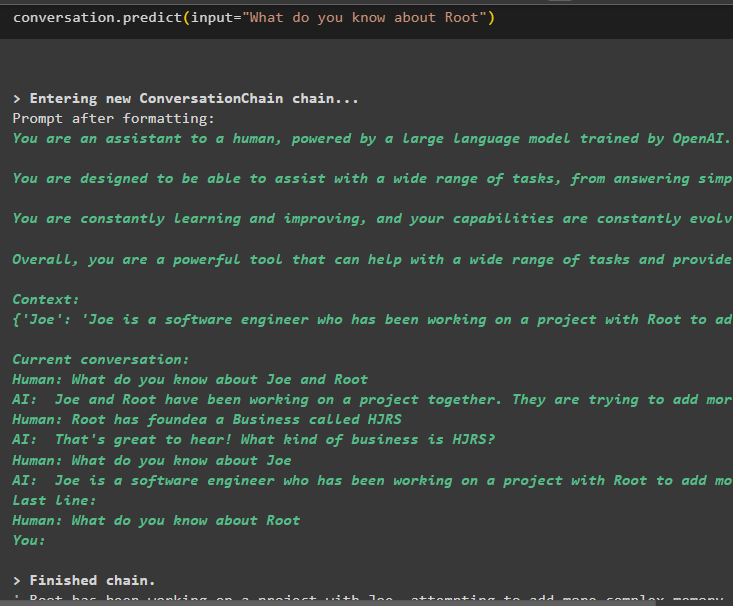

Ara extreu informació sobre una entitat específica mitjançant la consulta o el missatge definit a la variable d'entrada:

conversa. predir ( entrada = 'Què en saps de Root' )

Es tracta d'utilitzar la memòria de l'entitat mitjançant el marc LangChain.

Conclusió

Per utilitzar la memòria d'entitats a LangChain, només cal que instal·leu els mòduls necessaris per importar les biblioteques necessàries per crear models després de configurar l'entorn OpenAI. Després d'això, creeu el model LLM i emmagatzemeu les entitats a la memòria proporcionant informació sobre les entitats. L'usuari també pot extreure informació utilitzant aquestes entitats i construir aquestes memòries a les cadenes amb informació agitada sobre les entitats. Aquesta publicació ha explicat el procés d'ús de la memòria d'entitats a LangChain.