Aquesta guia il·lustrarà el procés d'execució de LLMChains a LangChain.

Com executar LLMChains a LangChain?

LangChain proporciona les funcions o dependències per crear LLMChains mitjançant els LLM/Chatbots i plantilles d'indicadors. Per conèixer el procés de creació i execució de LLMChains a LangChain, només cal que seguiu la següent guia pas a pas:

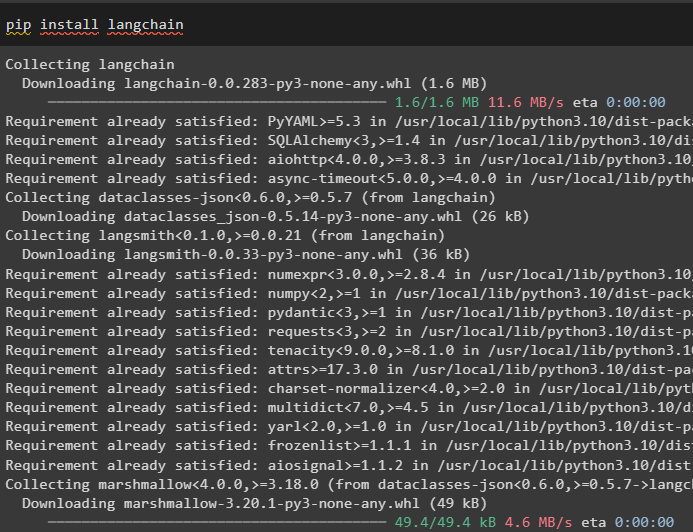

Pas 1: instal·leu paquets

Primer, comenceu amb el procés instal·lant el mòdul LangChain per obtenir les seves dependències per construir i executar LLMChains:

pip install langchain

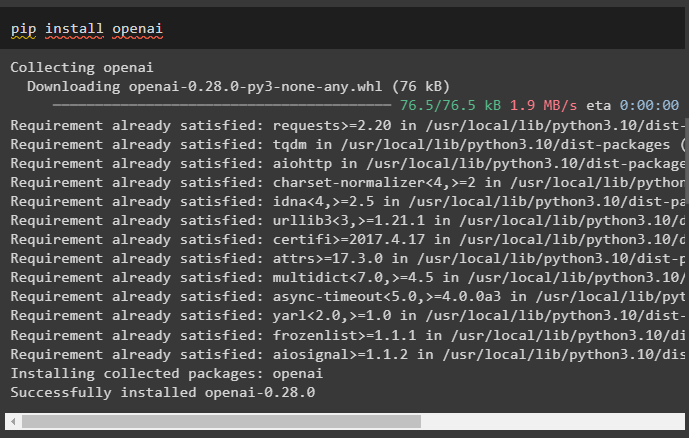

Instal·leu el marc OpenAI mitjançant l'ordre pip per aconseguir que les biblioteques utilitzin la funció OpenAI() per crear LLM:

pip install openai

Després de la instal·lació de mòduls, simplement configurar l'entorn variables utilitzant la clau API del compte OpenAI:

importar vostè

importar getpass

vostè . aproximadament [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'Clau de l'API OpenAI:' )

Pas 2: importa les biblioteques

Un cop finalitzada la configuració i instal·lats tots els paquets necessaris, importeu les biblioteques necessàries per crear la plantilla de sol·licitud. Després d'això, simplement creeu el LLM mitjançant el mètode OpenAI() i configureu el LLMChain mitjançant els LLM i la plantilla de sol·licitud:

des de langchain importar PromptTemplatedes de langchain importar OpenAI

des de langchain importar LLMChain

prompt_template = 'Doneu-me un bon títol per a l'empresa que fa {producte}?'

llm = OpenAI ( temperatura = 0 )

llm_cadena = LLMChain (

llm = llm ,

prompte = PromptTemplate. de_plantilla ( prompt_template )

)

llm_cadena ( 'roba de colors' )

Pas 3: Execució de cadenes

Obteniu la llista d'entrada que conté diversos productes produïts per l'empresa i executeu la cadena per mostrar la llista a la pantalla:

llista_entrada = [{ 'producte' : 'mitjons' } ,

{ 'producte' : 'ordinador' } ,

{ 'producte' : 'sabates' }

]

llm_cadena. aplicar ( llista_entrada )

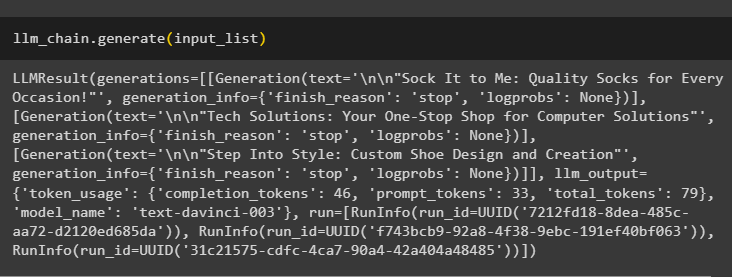

Executeu el mètode generate() utilitzant el llista_entrada amb LLMChains per obtenir la sortida relacionada amb la conversa generada pel model:

llm_cadena. generar ( llista_entrada )

Pas 4: Ús d'una entrada única

Afegiu un altre producte per executar els LLMChains utilitzant només una entrada única i, a continuació, prediu el LLMChain per generar la sortida:

llm_cadena. predir ( producte = 'mitjons de colors' )Pas 5: Ús de múltiples entrades

Ara, creeu la plantilla per utilitzar diverses entrades per proporcionar l'ordre al model abans d'executar la cadena:

plantilla = '''Explica'm una broma {adjectiu} sobre {subjecte}.'''prompte = PromptTemplate ( plantilla = plantilla , variables_entrada = [ 'adjectiu' , 'assignatura' ] )

llm_cadena = LLMChain ( prompte = prompte , llm = OpenAI ( temperatura = 0 ) )

llm_cadena. predir ( adjectiu = 'trist' , assignatura = 'ànecs' )

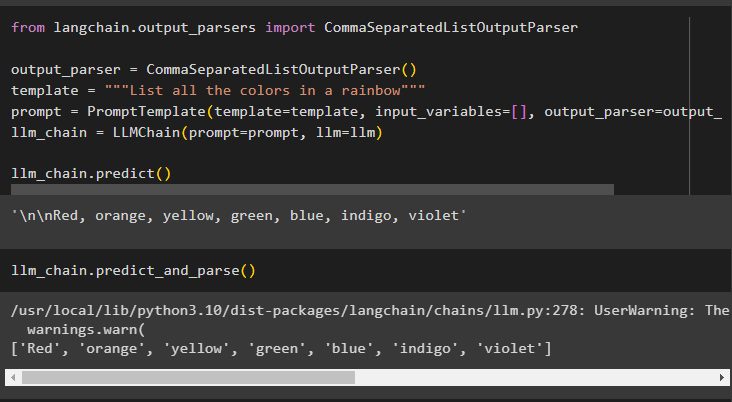

Pas 6: Ús de l'analitzador de sortida

Aquest pas utilitza el mètode de l'analitzador de sortida per executar el LLMChain per obtenir la sortida basada en la sol·licitud:

des de langchain. analitzadors_de_sortida importar CommaSeparatedListOutputParseranalitzador_sortida = CommaSeparatedListOutputParser ( )

plantilla = '''Llista tots els colors d'un arc de Sant Martí'''

prompte = PromptTemplate ( plantilla = plantilla , variables_entrada = [ ] , analitzador_sortida = analitzador_sortida )

llm_cadena = LLMChain ( prompte = prompte , llm = llm )

llm_cadena. predir ( )

L'ús del mètode parse() per obtenir la sortida generarà una llista separada per comes de tots els colors de l'arc de Sant Martí:

llm_cadena. predir_i_analitzar ( )

Pas 7: inicialització de cadenes

Aquest pas explica el procés d'utilitzar una cadena com a sol·licitud per executar el LLMChain mitjançant el model i la plantilla LLM:

plantilla = '''Explica'm una broma {adjectiu} sobre {subjecte}'''llm_cadena = LLMChain. de_cadena ( llm = llm , plantilla = plantilla )

Proporcioneu els valors de les variables a l'indicador de cadena per obtenir la sortida del model executant LLMChain:

llm_chain. predir ( adjectiu = 'trist' , assignatura = 'ànecs' )Es tracta d'executar els LLMChains mitjançant el marc LangChain.

Conclusió

Per crear i executar els LLMChains a LangChain, instal·leu els requisits previs com ara paquets i configureu l'entorn mitjançant la clau API d'OpenAI. Després d'això, importeu les biblioteques necessàries per configurar la plantilla i el model de sol·licitud per executar LLMChain mitjançant les dependències de LangChain. L'usuari pot utilitzar analitzadors de sortida i ordres de cadena per executar LLMChains tal com es mostra a la guia. Aquesta guia ha elaborat el procés complet d'execució de LLMChains a LangChain.