En aquest bloc, ens centrarem en les maneres en què podeu augmentar la utilització de la GPU a PyTorch.

Com augmentar l'ús de la GPU a PyTorch?

Hi ha diverses tècniques que es poden utilitzar per augmentar la utilització de la GPU i garantir que s'utilitzen els millors recursos de maquinari per al processament de models complexos d'aprenentatge automàtic. Aquestes tàctiques impliquen editar el codi i utilitzar les funcions de PyTorch. A continuació es mostren alguns consells i trucs importants:

- Càrrega de dades i mides de lot

- Models menys dependents de la memòria

- PyTorch Lightning

- Ajusteu la configuració del temps d'execució a Google Colab

- Esborra la memòria cau per a l'optimització

Càrrega de dades i mides de lot

El ' Carregador de dades ” a PyTorch s'utilitza per definir les especificacions de les dades que s'han de carregar al processador amb cada pas endavant del model d'aprenentatge profund. Un més gran' Mida del lot ” de dades requerirà més potència de processament i augmentarà la utilització de la GPU disponible.

La sintaxi per assignar un carregador de dades amb una mida de lot específica a PyTorch a una variable personalitzada es mostra a continuació:

Increase_GPU_Utilization = DataLoader ( Mida del lot = 32 )

Models menys dependents de la memòria

Cada arquitectura model requereix un volum diferent de ' memòria ” per rendir al seu nivell òptim. Els models que són eficients a l'hora d'utilitzar menys memòria per unitat de temps són capaços de treballar amb mides de lots molt més grans que les d'altres.

PyTorch Lightning

PyTorch té una versió reduïda que és ' PyTorch Lightning ”. Està optimitzat per a un rendiment ràpid com es pot veure pel seu nom. Lightning utilitza GPU de manera predeterminada i ofereix un processament molt més ràpid per als models d'aprenentatge automàtic. Un dels principals avantatges de Lightning és la manca d'exigència per al codi boilerplate que pot dificultar el processament.

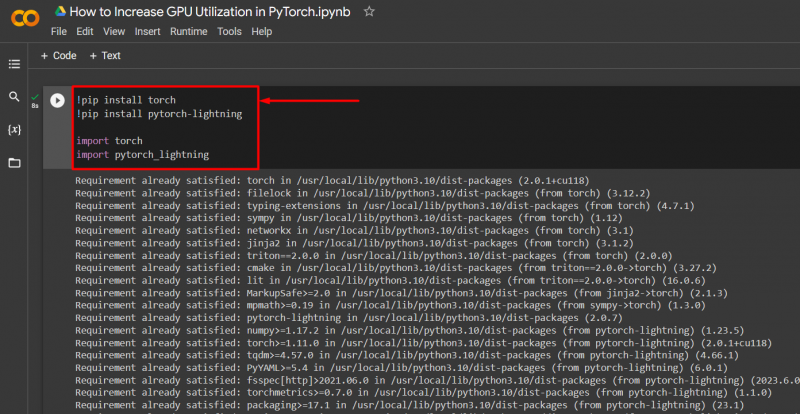

Importeu les biblioteques necessàries a un projecte PyTorch amb la sintaxi que es mostra a continuació:

! pip instal·lar torxa

! pip instal·lar pytorch - llamp

importar torxa

importar pytorch_lightning

Ajusteu la configuració del temps d'execució a Google Colab

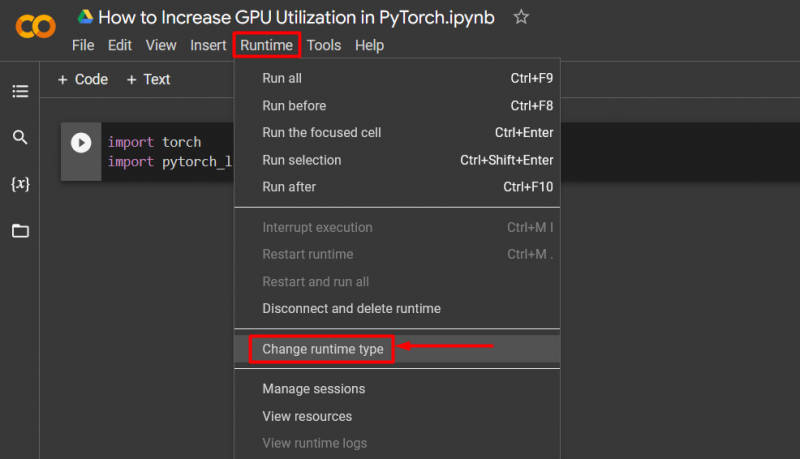

El Google Colaboratory és un IDE al núvol que proporciona accés gratuït a la GPU als seus usuaris per al desenvolupament de models PyTorch. Per defecte, els projectes Colab s'executen a la CPU, però la configuració es pot canviar.

Obriu el quadern de Colab, aneu a ' Temps d'execució ” a la barra de menús i desplaceu-vos cap avall fins a “ Canvia la configuració del temps d'execució ”:

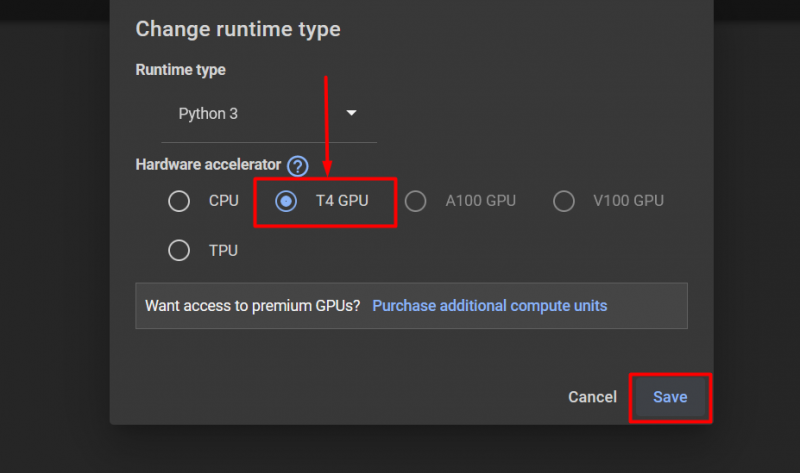

A continuació, seleccioneu 'GPU T4' opció i feu clic a ' Desa ” per aplicar els canvis per utilitzar la GPU:

Esborra la memòria cau per a l'optimització

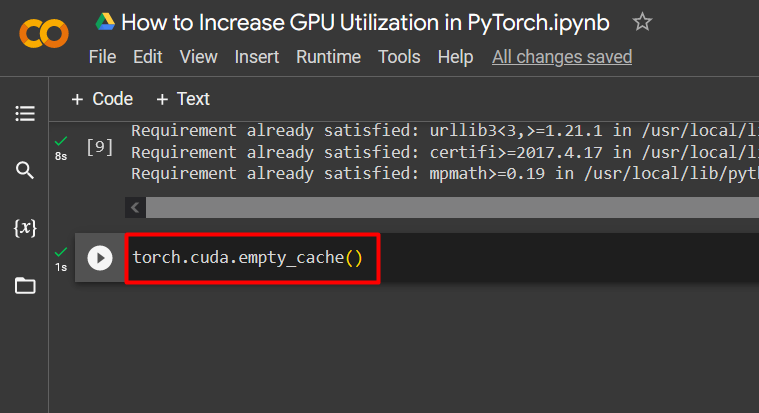

PyTorch permet als seus usuaris esborrar la memòria cau per poder alliberar espai perquè s'executin nous processos. El ' Memòria cau ” emmagatzema dades i informació sobre els models que s'executen perquè pugui estalviar temps que es dedicarà a recarregar aquests models. Esborrar la memòria cau proporciona als usuaris més espai per executar nous models.

L'ordre per esborrar la memòria cau de la GPU es mostra a continuació:

torxa. diferents . memòria cau_buida ( )

Aquests consells s'utilitzen per optimitzar el funcionament dels models d'aprenentatge automàtic amb GPU a PyTorch.

Pro-Tip

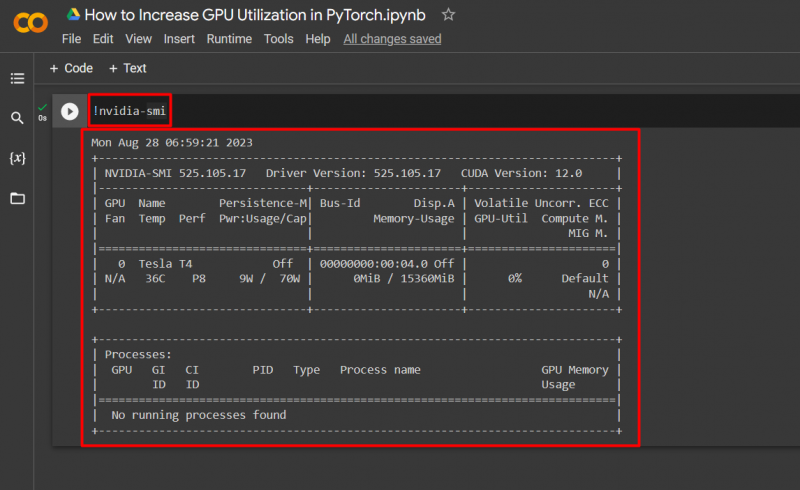

Google Colab permet als seus usuaris accedir a detalls sobre l'ús de la GPU mitjançant ' nvidia ” per obtenir informació sobre on s'utilitzen els recursos de maquinari. L'ordre per mostrar els detalls d'utilització de la GPU es mostra a continuació:

! nvidia - somriure

Èxit! Acabem de demostrar algunes maneres d'augmentar la utilització de la GPU a PyTorch.

Conclusió

Augmenteu la utilització de la GPU a PyTorch suprimint la memòria cau, utilitzant PyTorch Lightning, ajustant la configuració del temps d'execució, utilitzant models eficients i mides de lot òptimes. Aquestes tècniques contribueixen en gran mesura a garantir que els models d'aprenentatge profund funcionen al màxim i són capaços d'extreure conclusions i inferències vàlides a partir de les dades disponibles. Hem demostrat les tècniques per augmentar la utilització de la GPU.