La funció pipeline() és una part integral de la biblioteca Transformer. Es necessiten diverses entrades en les quals podem definir una tasca d'inferència, models, mecanisme de tokenització, etc. Una funció pipeline() s'utilitza principalment per realitzar tasques de PNL en un o diversos textos. Realitza el preprocessament de l'entrada i el postprocessament basat en el model per generar una sortida llegible per l'home i una predicció precisa amb la màxima precisió.

Aquest article tracta els aspectes següents:

- Què és la biblioteca de conjunts de dades Hugging Face?

- Com aplicar canalitzacions a un conjunt de dades a Hugging Face?

Què és la biblioteca del conjunt de dades Hugging Face?

Una biblioteca de conjunts de dades Hugging Face és una API que conté diversos conjunts de dades públics i ofereix una manera fàcil de baixar-los. Aquesta biblioteca es pot importar i instal·lar a l'aplicació utilitzant el ' pip ' comandament. Per obtenir una demostració pràctica per descarregar i instal·lar conjunts de dades de la biblioteca Hugging Face, visiteu aquesta pàgina Enllaç de Google Colab. Podeu descarregar diversos conjunts de dades des del Hugging Face Dataset Hub.

Obteniu més informació sobre el funcionament de la funció pipeline() consultant aquest article ' Com utilitzar la funció Pipeline () als transformadors? ”.

Com aplicar canalitzacions a un conjunt de dades a Hugging Face?

Hugging Face ofereix diversos conjunts de dades públiques diferents que es poden instal·lar fàcilment mitjançant un codi d'una línia. En aquest article, veurem una demostració pràctica de l'aplicació de canalitzacions a aquests conjunts de dades. Hi ha dues maneres d'implementar pipelines al conjunt de dades.

Mètode 1: Ús del mètode d'iteració

La funció pipeline() també es pot iterar sobre un conjunt de dades i un model. Per a això, seguiu els passos esmentats a continuació:

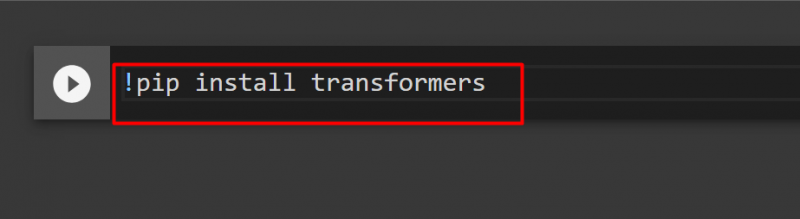

Pas 1: instal·leu Transformer Library

Per instal·lar la biblioteca Transformer, proporcioneu l'ordre següent:

!pip instal·lar transformadors

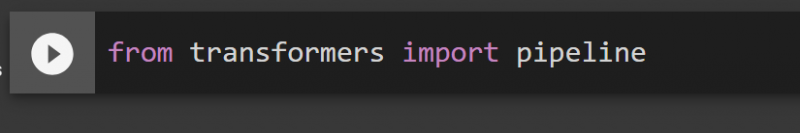

Pas 2: importació de canonades

Podem importar el pipeline des de la biblioteca Transformer. Per a això, proporcioneu l'ordre següent:

des de la canonada d'importació de transformadors

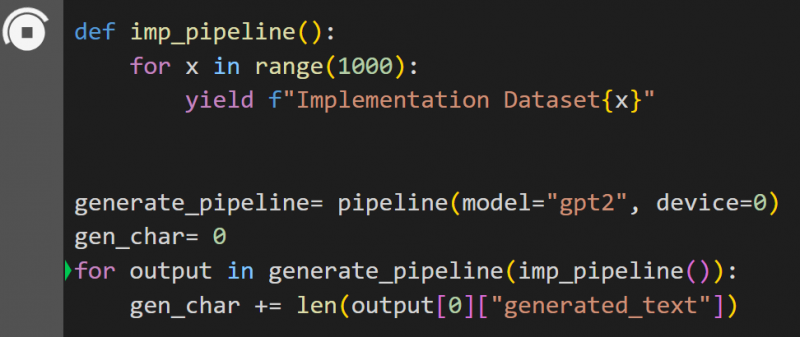

Pas 3: implementar Pipeline

Aquí, la funció pipeline() s'implementa al model ' gpt2 ”. Podeu descarregar models des de Hugging Face Model Hub:

def imp_pipeline():per a x en el rang (1000):

rendiment f'Conjunt de dades d'implementació{x}'

generate_pipeline= pipeline(model='gpt2', dispositiu=0)

gen_char= 0

per a la sortida a generate_pipeline(imp_pipeline()):

gen_char += len(sortida[0]['text_generat'])

En aquest codi, el ' generate_pipeline ” és una variable que conté la funció pipeline() amb el model “ gpt2 ”. Quan es diu amb el ' imp_pipeline() ”, reconeix automàticament les dades que s'incrementen amb l'interval especificat a 1000:

Això trigarà un temps a entrenar. L'enllaç al Google Co també es dóna.

Mètode 2: Ús de la biblioteca de conjunts de dades

En aquest mètode, demostrarem la implementació del pipeline mitjançant la biblioteca 'datasets':

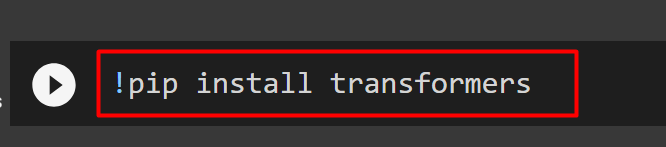

Pas 1: instal·leu el transformador

Per instal·lar la biblioteca Transformer, proporcioneu l'ordre següent:

!pip instal·lar transformadors

Pas 2: instal·leu la biblioteca de conjunts de dades

Com el ' conjunts de dades ” La biblioteca conté tots els conjunts de dades públics, podem instal·lar-lo mitjançant l'ordre següent. En instal·lar el ' conjunts de dades ” biblioteca, podem importar directament qualsevol conjunt de dades proporcionant el seu nom:

!pip instal·la conjunts de dades

Pas 3: Dataset Pipeline

Per crear una canalització al conjunt de dades, utilitzeu el codi següent. KeyDataset és una característica que només genera aquells valors que interessin a l'usuari:

des de transformers.pipelines.pt_utils import KeyDatasetdes de la canonada d'importació de transformadors

des de conjunts de dades import load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]') per a la sortida a gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Imprimeix la sortida ara')

imprimir ('----------------')

imprimir (sortida)

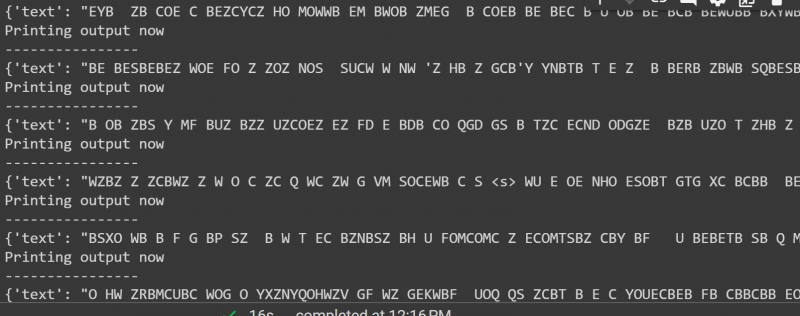

La sortida del codi anterior es mostra a continuació:

Això és tot d'aquesta guia. L'enllaç al Google Co també s'esmenta en aquest article

Conclusió

Per aplicar canalitzacions al conjunt de dades, podem iterar sobre un conjunt de dades mitjançant una funció pipeline() o bé utilitzar el ' conjunts de dades ” biblioteca. Hugging Face proporciona l'enllaç del dipòsit de GitHub als seus usuaris tant per a conjunts de dades com per a models que es poden utilitzar segons els requisits. Aquest article ha proporcionat una guia completa per aplicar canalitzacions en un conjunt de dades a Transformers.