En aquesta època, els Transformers són els models més potents que han proporcionat els millors resultats en múltiples operacions de NLP (processament del llenguatge natural). Inicialment, es va utilitzar per a tasques de modelatge d'idiomes, com ara la generació de text, així com la classificació, la traducció automàtica i molts més. Però ara, també s'utilitza per al reconeixement d'objectes, la classificació d'imatges i moltes altres tasques de visió per ordinador.

En aquest tutorial, proporcionarem el procediment per realitzar la classificació de text mitjançant Transformers.

Com realitzar una classificació de text amb transformadors?

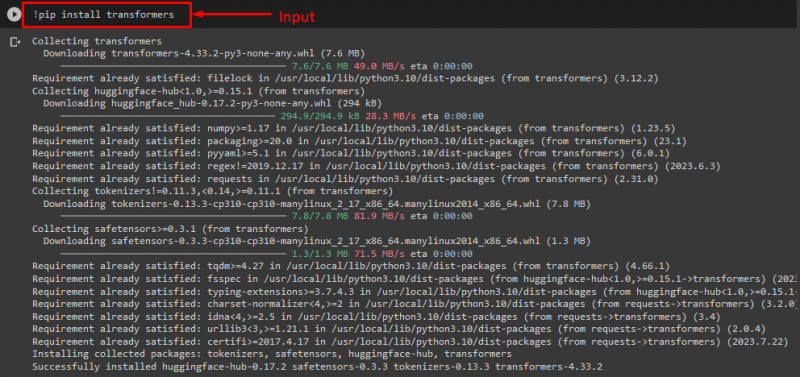

Per realitzar la classificació de text amb Transformers, en primer lloc, instal·leu el ' transformadors ” biblioteca executant l'ordre proporcionada:

! pip instal·lar transformadors

Com podeu veure, la biblioteca especificada s'ha instal·lat correctament:

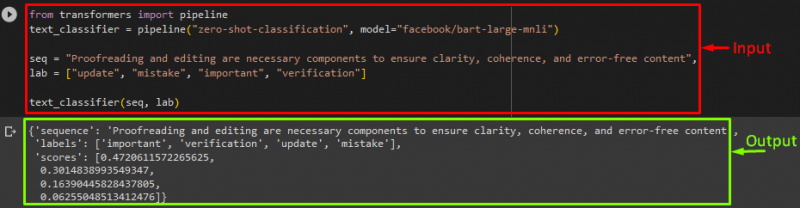

A continuació, importeu el ' canonada ' de la ' transformadors ” biblioteca:

des de la canonada d'importació de transformadors

Aquí, el ' canonada ” inclourà la tasca de PNL que hem de realitzar i el model de transformador desitjat per a aquesta operació juntament amb el tokenitzador.

Nota: El tokenitzador s'utilitza per processar el text que es proporcionarà l'entrada del model separant el text en fitxes.

Després d'això, utilitzeu el ' pipeline () ” i passa-li la funció “ classificació zero-shot ” com a argument. A continuació, passeu un altre paràmetre que és el nostre model. Estem utilitzant el ' BART ” model de transformador. Aquí, no fem servir el tokenizer perquè es pot inferir automàticament pel model especificat:

text_classifier = canalització ( 'classificació de tir zero' , model = 'facebook/bart-large-mnli' )

Ara, declara el ' seq ” variable que conté el nostre text d'entrada que cal classificar. A continuació, proporcionem les categories en les quals volem classificar el text i desar-lo a la ' laboratori ” que es coneix com a etiquetes:

laboratori = [ 'actualitzar' , 'errada' , 'important' , 'verificació' ]

Finalment, executeu el pipeline juntament amb l'entrada:

Després d'executar el pipeline, com podeu veure, el model va predir la nostra seqüència proporcionada per ser classificada:

Informació adicional: Si voleu accelerar el rendiment del model, heu d'utilitzar la GPU. En cas afirmatiu, per a aquest propòsit, podeu especificar un argument de dispositiu a la canalització i establir-lo a ' 0 ” per utilitzar la GPU.

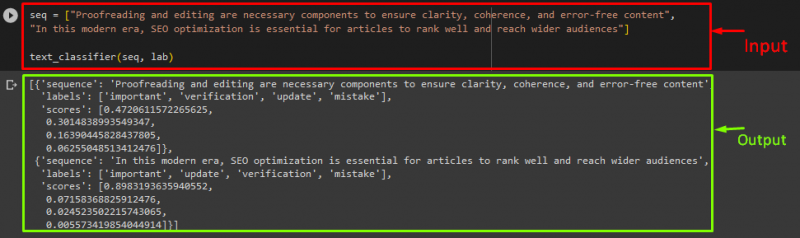

Si voleu classificar el text en més d'una instrucció de text d'entrada/seqüència, podeu afegir-los a una llista i passar-lo com a entrada a les canalitzacions. Per a això, consulteu el fragment de codi:

seq = [ 'La correcció i l'edició són components necessaris per garantir la claredat, la coherència i el contingut sense errors' ,'En aquesta era moderna, l'optimització de SEO és essencial perquè els articles es classifiquen bé i arribin a un públic més ampli' ]

classificador_text ( seq , laboratori )

Sortida

Això és! Hem recopilat la manera més senzilla de realitzar la classificació de text amb Transformers.

Conclusió

Els transformadors s'utilitzen per realitzar tasques de modelatge de llenguatge, com ara la generació de text, la classificació de text i la traducció automàtica, així com tasques de visió per ordinador, com ara el reconeixement d'objectes i la classificació d'imatges. En aquest tutorial, hem il·lustrat el procés per realitzar la classificació de text mitjançant Transformers.